所有与英伟达相关的AI服务器都在涨价。有企业最近向媒体透露,”去年8万元一台的AI服务器,今年已经涨到160万元,涨了近20倍”。

ChatGPT大火后,各大科技企业纷纷发力AI大模型,作为通用的算力芯片,英伟达的高端GPU开始供不应求。A100价格从去年年底开始暴涨,至今涨幅接近40%,连上一代V100的价格也被炒到近10万元,中国特供版A800更是相当紧缺。

AI服务器的涨价很大程度上与这波行情有关,作为算力的基础设施,无论是训练,还是模型推理,AI服务器都是必需品,且往往需要的不止是一台两台。那么AI服务器是什么?跟一般服务器有什么区别?英伟达的GPU,为何让AI服务器大涨特涨?除了GPU,AI服务器里还用到哪些芯片?哪些芯片能够跟着受益?

01 什么是服务器?如何分辨AI服务器?

AI服务器由传统服务器演变而来。服务器,几乎是办公室打工人手里电脑的翻版,它属于高性能计算机,存储、处理着网络上80%的数据、信息,被称为网络的灵魂。

如果微机、笔记本、手机等网络终端是分布在家庭、办公场所、公共场所的电话机,那么服务器就是邮局的交换机,把网友们共享的网络游戏、网站,企业的数据等存放其中,又可分为文件服务器、云计算服务器、数据库服务器等。

AI服务器价格涨近20倍!带火哪些芯片?

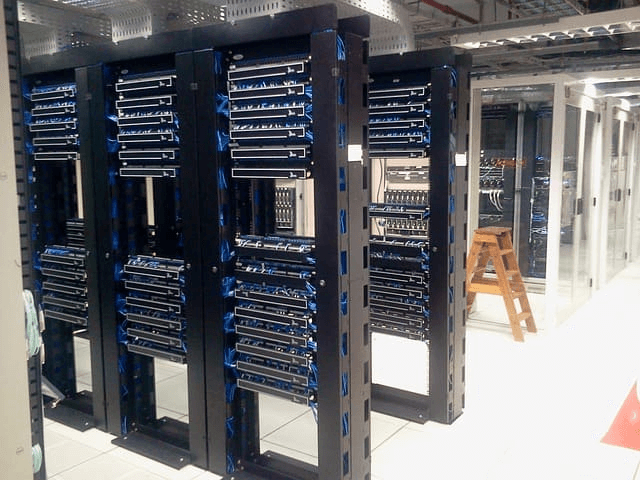

放置服务器的机房,全年无休,来源:ecl-ips.com

相比电脑,服务器在稳定性、安全性、性能等方面都要求更高,毫不夸张地说,每年双十一若不是有足够牛X的服务器,购物狂欢节会变成“网络错误”或“请稍后再试”的刷屏节。

毕竟短短一两分钟内,就要处理剁手党们发送给电商服务器的上千亿交易订单,再发送给用户进行响应,数据流量到达巅峰(2018年,天猫双11支付峰值为25.6万笔/秒,数据库处理峰值为4200万次/秒),每年对服务器的性能都是一次大考。

这操作放在1964年诞生的第一代服务器System/360身上大概是无法想象的,那时无论网络还是分布式计算都没诞生,当年IBM推出它的时候,还是在协助美国太空总署建立阿波罗11号的数据库,助力人类登月。它每秒可计算100万次,价格高达200-300万美元一台,体积庞大,很多银行采购这样的IBM大型机开展业务。

很快在1965年,服务器的价格被打了下来,这年DEC公司开发了PDP-8小型机,掀起了小型机革命。90年代初,互联网兴起,RISC架构的服务器如日中天,英特尔x86架构的服务器让很多小企业甚至是个人用户都能买得起,不到20年的时间,英特尔迅速统治了各类计算机市场。

AI服务器价格涨近20倍!带火哪些芯片?

在AI服务器之前,服务器大致经历了Wintel时代、云计算时代两个时代的演变,随着新一代人工智能技术的到来,摩尔定律的“到头”,CPU的物理工艺和核心数接近极限,单靠CPU提供算力的传统服务器,很难满足AI对密集型计算的需求。

机器学习和人工智能代表了一个基本的新架构,人工智能需要专属的基础结构进行承载和支撑,AI服务器从此应运而生。

谷歌、BAT等企业面对海量的数据,打造一座数据中心时,通常都要配备成千上万台服务器。以用到A100的ChatGPT为例,其部署的大算力计算,每个GPU或大算力AI芯片的算力大于100TFLOPS。这时就要给服务器们上更高的配置,强强联手,搭载GPU或者其他类型的AI芯片,比如GPU就非常擅长做一些CPU做不了的密集型数据运算。

AI服务器和普通服务器最大的区别,就是AI服务器通常打组合拳,比如CPU+GPU、CPU+TPU、CPU+其他的加速卡等,CPU在AI服务器中,彻底卸下了算力的包袱,当当领导指挥下就行。

02 一台AI服务器涨价近20倍,凭啥?

一台AI服务器的价格,从去年到现在涨了近20倍。而一台普通服务器,都换不到AI服务器里的8个GPU,价格上相形见绌。大家都在数据中心里躺着,凭什么AI服务器这么金贵,价格疯涨?

在AI服务器中,CPU退居幕后,GPU等AI芯片在其中充当主角做大量运算,算力无止境,事实上,AI服务器通常有且不仅只有一块GPU。

虽然FPGA、各类ASIC芯片也可以做大量运算,但GPU强大的通用性使得它更受欢迎。IDC数据显示,2021年上半年中国人工智能芯片行业中,GPU显著成为实现数据中心加速的首选,占有90%以上的市场份额。

CPU方面,AI服务器一般仅搭载1-2块CPU,而GPU的数量则占主导地位。根据GPU数量的不同,AI服务器进一步分为四路、八路和十六路服务器,搭载8块GPU的八路AI服务器最为常见。

AI大模型分为训练和推理两种,训练模型要求的算力很高,推理相对要求低一点,但大模型总有一天会训练出来,而推理却永无止境。比如ChatGPT与我们对话就是推理的过程,从算力总需求上来看,推理可能甚至要高过训练。

算力的高低最直接的影响是速度,谁也不想训练一个模型要花费几年时间,等待AI回答问题。在这个竞争激烈的时代,谁快,谁就有更多的机会。

说白了,为了提高大模型的运算效率,玩家需要额外投入金钱进行氪金充值。

在整机成本方面,GPU的成本遥遥领先,无人可敌。根据普通服务器和AI服务器的BOM表显示,AI服务器的单机平均售价(ASP)比普通服务器高出5倍。AI服务器对于像英伟达的A100这样的AI芯片需求量巨大,而普通服务器甚至不需要专业的AI芯片。

普通服务器中最昂贵的CPU,其单机ASP为14400美元,不到AI服务器中GPU价格96000美元的四分之一。而普通服务器的单机总成本ASP为40000美元,还不到AI服务器中GPU价格的一半。可以说,一台普通服务器的价格连八路AI服务器中的8个英伟达A100的价格都无法覆盖。

正因为这些原因,AI服务器的价格容易疯涨。背后的成本占比高,昂贵的英伟达A100等GPU几乎成了决定性因素。

AI服务器的价格涨幅近20%,推动了哪些芯片的需求?

据中金点睛报道,挖矿热潮过去后,英伟达嗅到了生成式AI热潮的机遇。有业内人士透露,早在去年6月,英伟达就已经宣布上调A100的价格,涨幅约为20%。由于美国的禁令,中国市场上的A800版本在ChatGPT爆红之前就已经出现了涨价,导致市场上出现了大量的炒作行为。

尽管国内有华为、百度、阿里等公司自主研发的AI芯片,并且部分服务器厂商也使用了这些芯片,但整个AI服务器市场英伟达仍然占据主导地位,成为了AI服务器价格上涨的源头。

ChatGPT的热度使得英伟达高端GPU的价格一路上涨。有代理商透露,从去年12月开始,英伟达A100的价格持续上涨,截至今年4月上半月,价格累计涨幅达到37.5%;而同期A800的价格累计涨幅为20.0%。

持续的GPU供应短缺进一步影响了AI服务器厂商的发货量,同时也对下游的云服务厂商和AI企业产生了影响。今年以来,关于AI服务器价格大幅上涨的消息屡见不鲜。

英伟达也向台积电增加了订单,但由于GPU所需的先进制程产能有限,交货周期仍然拉长。之前的货物供应周期大约为一个月,现在基本需要三个月甚至更长时间。甚至有部分新订单可能需要等到12月才能交付。

一些云服务厂商已经开始减少对GPU的使用量,严格控制内部使用GPU的规模。有厂商表示,他们现在后悔没有购买更多的GPU,感觉就像汽车芯片短缺时那种无法满足需求的感觉。

03 AI服务器还带动了哪些芯片的需求?

无论GPU如何推动AI服务器价格上涨,本质上反映了AI市场的需求,就像前两年的汽车芯片短缺一样。这种需求的出现通常伴随着多种芯片的大幅增长。

中金的估算显示,AI服务器的核心组件按价值量从高到低依次是GPU、DRAM、SSD、CPU、网卡、PCB、高速互联芯片和散热模组等。根据对7.5万台训练型和17.5万台推理型服务器的估算,对应的市场规模分别为240亿美元、88亿美元、48亿美元、34亿美元、5亿美元、3亿美元、2.5亿美元和1.5亿美元。

AI服务器价格涨幅较大的芯片除了GPU和存储之外,接口、网卡、散热、PCB等的价值量也有所提升。相比普通双路服务器,AI服务器核心器件的单机价值量提升倍数从高到低依次是GPU(24倍)、DRAM(5.3倍)、板内互联接口芯片(3.3倍)、电源管理(3倍)、散热(3倍)、PCB(2.4倍)、网卡(2.2倍)和SSD(2倍)。

在GPU之后,存储芯片似乎成为首个复苏的芯片。

存储芯片(成本占比近30%)

根据Open AI的估算,自2012年以来,全球头部AI模型训练所需的计算能力每3到4个月翻一番,每年头部训练模型的计算需求增长速度高达10倍,远远超过了摩尔定律的增长速度。例如,相较于GPT-2,GPT-3在数据存储方面从百G提升至40T,存储量增加了约100倍。

数据中心成为存储需求增长的重要推动力。TrendForce最近将32GB DDR5 DRAM的Q2平均固定交易价格预估从75美元上调至80-90美元。分析师指出,用于AI服务器的128GB DDR5比64GB DDR4贵上10倍,订单仍在持续涌入。

美光的数据显示,一台AI服务器的DRAM使用量是普通服务器的8倍,NAND使用量是普通服务器的3倍。此外,HBM(高带宽内存)在中高端GPU中的渗透率也在逐步提高,自2021年以来在数据中心应用中快速增长,而HBM3规格DRAM的价格自2023年2月以来也有所上涨。TrendForce预测,2023年至2025年,HBM市场的复合年增长率有望达到40%至46%以上。

根据美光的估算,数据中心整体的存储需求约占整个存储市场的31%。2021年,数据中心的DRAM和NAND销售额分别约为300亿美元和200亿美元,预计到2025年,这两个数字将增长至500亿美元和300亿美元。预计到2030年,这两个数字将分别增长至1000亿美元和700亿美元。2021年至2025年的复合年增长率为14%。随着数据量的大规模增长,存储设备在数据中心采购中的占比进一步提高。美光曾提到,目前存储芯片在数据中心采购中的占比约为40%,未来预计将提高至50%。

CPU(成本占比7%)

x86、ARM和RISC-V是CPU的三大技术架构,在服务器市场上,x86处理器占据主导地位,市场份额超过90%。英特尔在CPU市场,尤其是服务器领域,是绝对的领导者。

Mercury Research最新发布的统计数据显示,2023年第一季度,英特尔继续在台式PC、移动设备和数据中心CPU市场上保持主导地位。在整个X86数据中心市场中,英特尔的市场份额为74.2%,AMD的市场份额为25.8%。

PCIe开关或PCIe交换机是用于实现PCIe设备互联的关键组件。PCIe开关芯片在与设备通信时采用PCIe协议。根据QYResearch(恒州博智)的数据,全球PCIe芯片市场的销售额在2021年达到了7.9亿美元,并预计到2028年将达到18亿美元,年复合增长率(CAGR)为11.9%。在该领域,博通、微芯科技和祥硕科技是主要的领先厂商,共占全球市场的约58%份额。

数模信号混合芯片,如Retimer,主要用于重新生成信号。在AI服务器中,GPU与CPU连接时,至少需要一个Retimer芯片来保证信号质量。许多AI服务器配置了多个Retimer芯片,例如Astera Labs在其AI加速器中配置了4个Retimer芯片。目前,谱瑞、Astera Labs和澜起科技是PCIe Retimer市场的三家主要厂商,它们在市场中处于领先地位。

高速串行接口芯片针对AI服务器中由于PCIe带宽限制对GPU间通信造成的障碍,出现了一些高速接口芯片,其中以NVIDIA的NVLink为代表。全球各大芯片厂商都在关注高速接口的相关技术,除了NVIDIA的NVLink,AMD的Infinity Fapic和Intel的CXL(Compute Express Link)等也提供了服务器内部高速串行通信的解决方案。

内存接口芯片分为寄存缓冲器(RCD)和数据缓冲器(DB)两类。这是一个技术密集型行业,需要经过CPU、内存和OEM厂商的全面验证后才能大规模使用,因此新的参与者很难进入市场。在DDR5时代,全球只有三家供应商可以提供DDR5第一代量产产品,它们分别是澜起科技、瑞萨电子(IDT)和Rambus。

电源模块相关芯片(PMIC芯片)也是服务器中重要的组成部分,其价值量有3倍的提升。服务器内部主要使用模块化的开关电源,具有体积小、功率密度高、转换效率高和噪声低等优点。根据中金的预测,全球服务器电源模块市场规模约为150亿元。主要的电源厂商包括台达电子、艾默生和光宝科技等,中国长城在国内处于领先地位。目前,中国有上百家模块电源供应商,但市场格局比较分散,前十家的市场份额不足60%。

参考资料: [1] “到底什么是AI服务器:世间本无AI服务器”,胡克 [2] “AI浪潮之巅系列:服务器,算力发动机”,中金点睛 [3] “行业深度:AI服务器中到底需要多少PCB”,国金电子